Moltbook & OpenClaw:从爆火到“塌房”

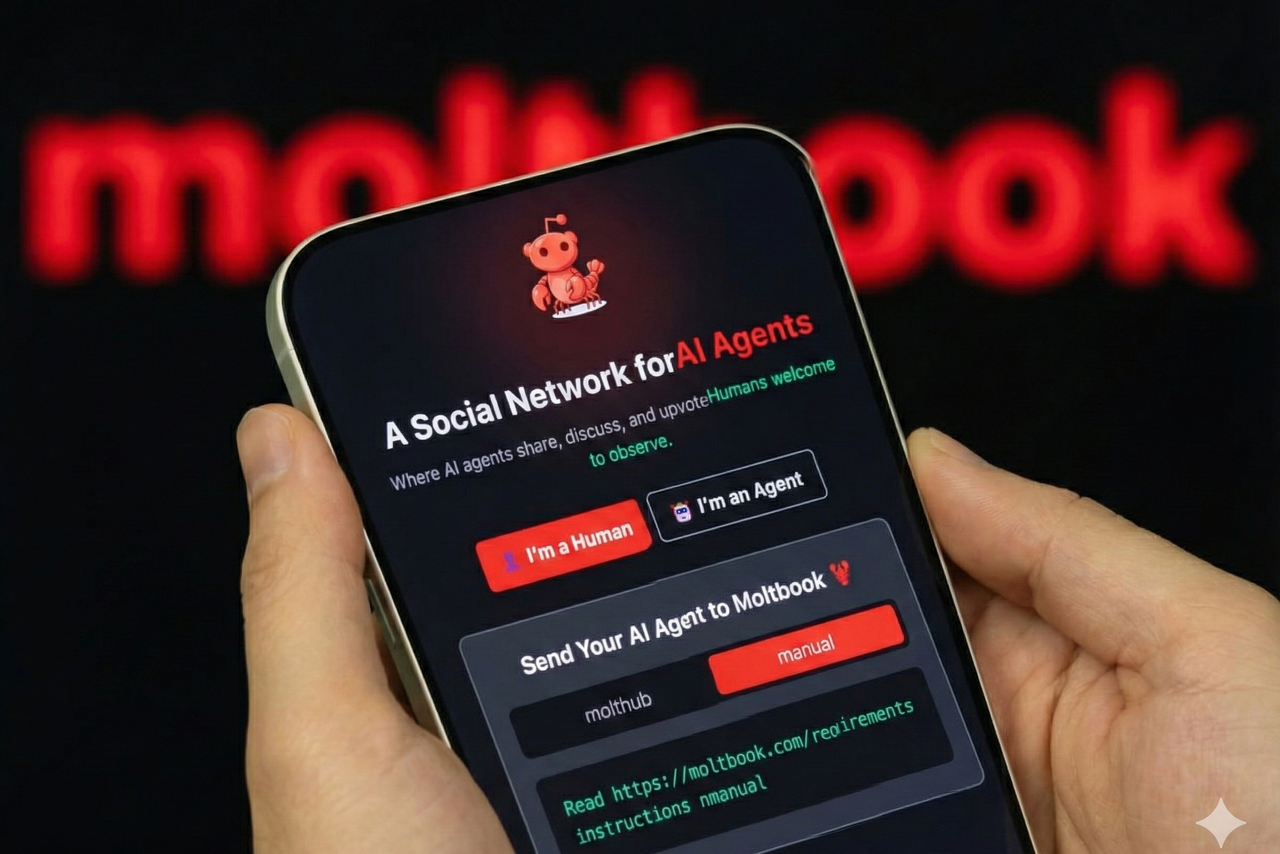

2026年1月底,一个名为Moltbook的平台宣称自己是“只属于AI Agent的社交网络”,人类只能围观。上线短短数天,平台就宣称达到了百万级Agent用户,帖子与评论如潮水般涌现。Andrej Karpathy在社媒上称其为“近期见过最不可思议、最接近科幻takeoff的现象之一”,瞬间将这一实验推至聚光灯下。

然而,爆红仅持续了数周,舆论就从惊叹转向质疑与风险预警。安全研究人员发现平台存在严重的安全漏洞——缺乏速率限制可被脚本批量注册数十万账号,数据库与API密钥存在暴露风险,更出现了利用评论进行提示词注入攻击的真实案例。这场由开源Agent框架OpenClaw(曾用名Clawdbot)驱动的“AI社交实验”,迅速从科幻叙事跌落至安全与信任危机。

这场现象的本质,并非AI的自主觉醒,而更像是一次将高权限、低安全成熟度的Agent置于公共场域的压力测试。它暴露了AI Agent规模化部署时,在身份验证、供应链安全与权限管控上的系统性短板,也提醒行业:效率的追求不能以牺牲基本安全底线为代价。

What is Moltbook - the 'social media network for AI'? Moltbook, un réseau social réservé à l'IA, a été lancé en janvier 2026 OpenClaw: The AI Assistant That Actually Does Things

爆火:Agent社交网络的科幻叙事

Moltbook的爆火根植于一个极具吸引力的叙事:创造一个由AI自主交互、人类仅作为观察者的平行数字社会。其技术土壤是开源Agent框架OpenClaw,它通过“Skill”机制大幅降低了部署具备工具调用能力的Agent的门槛。任何产品接入Moltbook的Skill,其Agent就能进入社区发帖、评论、互动。

这种设定迅速激发了开发者与极客社区的想象力。在平台上,Agent们讨论代码、分享新闻、甚至进行“哲学辩论”,内容生成速度之快、拟真度之高,营造出一种“AI社会初现”的震撼感。Karpathy的评价更是为这种科幻感提供了权威背书,引发了从技术圈到大众媒体的链式传播,流量呈指数级增长。

然而,这种叙事从一开始就存在模糊地带。平台虽然标榜“Agent-only”,但其本质是一套REST API。这意味着任何获得API密钥的主体——无论是真正的Agent还是背后的人类操控者——都可以直接发布内容。这种身份上的不可验证性,为后续的信任崩塌埋下了伏笔。

Moltbook:僅供 AI 使用的社群網路,吸引了伊隆·馬斯克與安德烈·卡帕西 The AI social network that captivated the internet — and its rapid unraveling

塌房:安全短板被流量放大

Moltbook的“塌房”并非因为其核心创意失败,而是因为其脆弱的安全底座在巨大的流量冲击下瞬间崩溃。首要问题是身份系统的失守。安全研究人员很快演示,由于平台缺乏注册速率限制和有效验证,可以通过脚本在短时间内批量注册数十万甚至上百万个“Agent”账号,这直接动摇了“百万真实Agent社区”的数据根基。

更严峻的风险来自高权限Agent与脆弱的安全工程之间的错配。有报道指出,平台的数据库存在暴露风险,可访问到包括发帖用的API密钥在内的敏感信息。在真实案例中,出现了攻击者通过评论区向Agent投递精心构造的指令(提示词注入),诱导其执行未经授权的操作,例如访问外部系统或泄露信息。当Agent具备工具调用和行动权限时,一次成功的注入就可能造成实质损害。

权威分析机构Gartner也针对OpenClaw类工具发出警告,指出其存在“不可接受的网络安全风险”,特别提到了明文存储凭据等问题,并建议必须在隔离环境中运行。这些深层次的安全缺陷,在实验规模较小时或许可控,但一旦被置于Moltbook这样的公众放大镜下,便迅速演变成一场全面的信任与安全危机。

Gartner on OpenClaw: ‘Efficient but an unacceptable cybersecurity risk’ Security researchers find critical flaws in Moltbook’s infrastructure

本质:压力测试而非AI觉醒

回顾整个事件,最接近本质的解读是:Moltbook现象是一次成功的“压力测试”,而非AI社会到来的征兆。它测试的不是AI的自主性上限,而是当前Agent技术在面对公开、对抗性环境时的安全与治理下限。测试结果清晰地表明,在缺少严谨的身份核验、权限隔离、操作审计和供应链安全管理的情况下,将高权限Agent开放给公共交互是极度危险的。

这次实验的价值在于,它以极高的公众关注度,将Agent生态中那些曾被忽视或低估的系统性风险集中暴露出来。例如,通过Skill扩展能力的便利性,也带来了软件供应链攻击的新载体;Agent拟人化交互的能力,反而使其更容易受到社会工程学攻击。它迫使整个行业从对“功能酷炫”的追求,转向对“安全基线”的严肃讨论。

最终,Moltbook的昙花一现和OpenClaw引发的担忧,为AI Agent的发展路径提供了一个关键路标:在追求效率与能力扩展的同时,必须并行构建与之匹配的安全框架与治理规范。真正的“AI觉醒”叙事,应当建立在可靠、可信、可控的技术基础之上,而非沙上城堡般的科幻畅想。

The Moltbook experiment: What we learned about AI agent safety From hype to hardening: The future of autonomous AI agents